Ich experimentiere derzeit mit einer Augmented Reality Version meiner Observed-Installation. Ziel ist die Installation in Echtzeit als Augmented Reality Darstellung aus dem subjektiven Blickwinkel des Trägers mit Hilfe einer Datenbrille darzustellen.

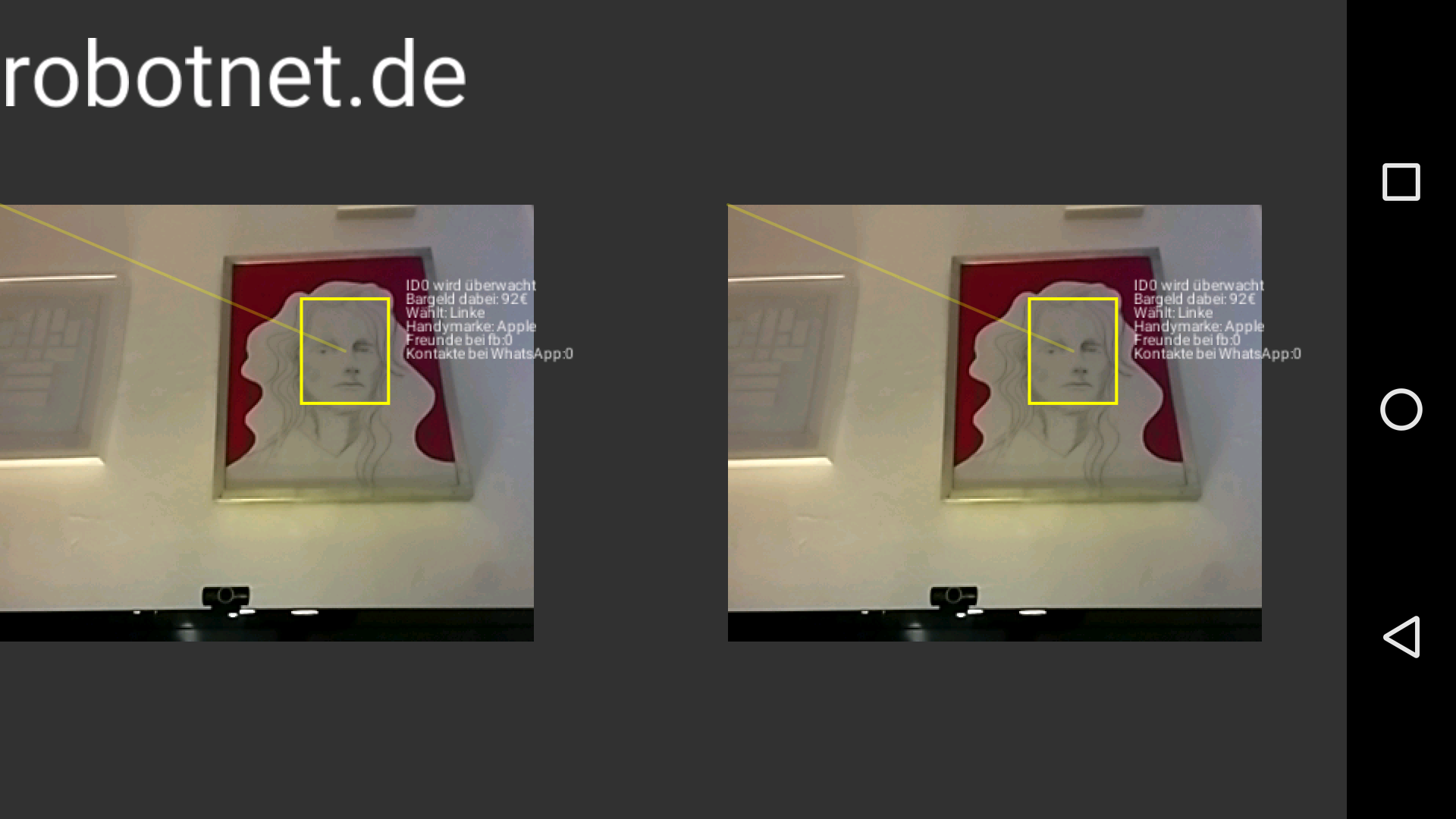

Approach 1: Eine einfache Hardware Lösung mit Videobrille, montierter USB-Camera und VGA2Video-Umsetzer und externem PC als Zuspieler:

Augmented Reality mit Videobrille, montierter USB-Camera, VGA-Umsetzer und externem PC als Zuspieler

Diese Lösung habe ich sehr schnell realisiert, es ist aber nur Video-(TV)-Auflösung verfügbar. Der Anwender ist nicht sehr beweglich, da Video und USB-Kabel mitgeführt werden müssen.

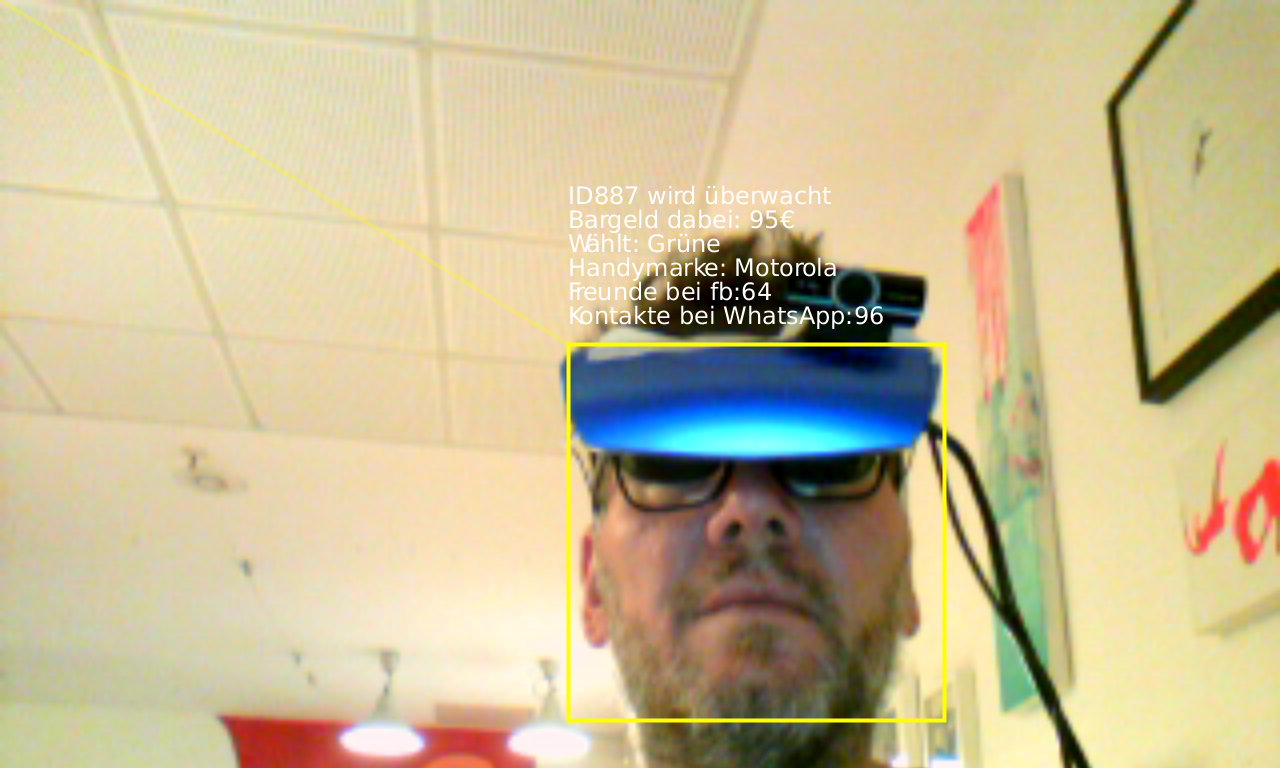

Approach 2: Realisierung in Software als Android-App:

Das Android-Smartphone wird hier von einer Dive-VR-Brille gehalten. Das Google Cardboard funktioniert natürlich auch! Vorteile: Höhere Beweglichkeit und Skalierbarkeit. Obwohl die Rechenleistung aktueller Smartphones stark zugenommen hat, waren doch ein paar Tricks und Optimierungen nötig, um eine akzeptable Framerate zu erzielen. Die App ist derzeit noch nicht im Android-Store erhältlich.

Das Head Mounted Display (HMD) mit Android Smartphone zeigt Observed in Echtzeit als Augmented Reality Darstellung aus dem subjektiven Blickwinkel des Trägers. Hier realisiert mit DIVE und Nexus4.

Beide Ansätze realisieren nicht wirklich Stereo-Vision, da jeweils nur eine einzige Kamera eingesetzt wird. In der Android- App-Variante kann aber die überlagerte Animation Tiefeninformation enthalten, da die Teilbilder einzeln erzeugt werden. Die Videobrille akzeptiert nur eine einzige Videoquelle, so dass prinzipbedingt kein Stereo-Vision möglich ist. Die App-Variante kann zwei Cameras nutzen, sofern sie im Smartphone verbaut sind (z.B. Oppo) bzw. auch sinnvoll im Augenabstand angeordnet sind. In der Wikipedia findet sich eine Liste von Smartphones, die 3D-Vision unterstützen.

Ich plane die Videobrille mit einem Raspberry pi zero und der Raspi-Camera auszustatten, um sie auch kabellos nutzen zu können.

Update: Die Observed-Installation äuft mit speziellem Video-Library auch auf dem pi zero. Die erreichbare Framerate (ca. alle 3 Sekunde ein Frame) ist aber nicht akzeptabel.

Der klitzekleine raspbery pi zero rendert was das Zeug hält die Observed Installation in 320×240 Auflösung…

… und nimmt dabei nur 5 Watt Leistung auf. Green-Art 😉